Python深度学习手势识别的项目介绍

该项目使用了Kaggle上的手语字母数据集,包含了26个手语字母的图像数据,总计约27,000张图片。最后,我们需要将数据集划分为训练集和测试集,一般采用80%的数据作为训练集,20%的数据作为测试集。本项目使用了Kaggle上的手语字母数据集,该数据集包含了26个手语字母的图像数据,总计约27,000张图片。- 两个全连接层,第一个全连接层包含128个神经元,第二个全连接层包含26个神经元(对应

本博客将介绍一个基于Python深度学习的手势识别项目,旨在通过训练一个卷积神经网络(CNN)模型,实现对手语字母的识别。该项目使用了Kaggle上的手语字母数据集,包含了26个手语字母的图像数据,总计约27,000张图片。通过该项目,我们可以学习到如何处理图像数据、构建CNN模型、训练和优化模型,以及如何对模型进行评估和调优。

项目背景和目的

手语是一种重要的非语言交流方式,它被广泛应用于聋哑人士之间的交流。手语字母是手语中最基本的元素之一,它们是组成手语词汇和句子的基本单元。因此,对手语字母的准确识别具有重要的实用价值。本项目的目的就是通过深度学习技术,对手语字母进行识别,为聋哑人士提供更加便捷的交流方式。

数据集介绍

本项目使用了Kaggle上的手语字母数据集,该数据集包含了26个手语字母的图像数据,总计约27,000张图片。每张图片的大小为200x200像素,颜色为RGB格式。数据集已经按照字母进行了分类,并且每个字母的图片数量相等。因此,该数据集是一个非常适合用于训练深度学习模型的数据集。

数据预处理

在读取数据之前,我们需要对数据进行预处理。首先,我们需要将图片的像素值归一化到0-1范围内,这样可以加快模型的训练速度。其次,我们需要将标签进行one-hot编码,这样可以方便地将标签输入到模型中进行训练和评估。最后,我们需要将数据集划分为训练集和测试集,一般采用80%的数据作为训练集,20%的数据作为测试集。

下面是数据预处理的代码实现:

网络结构

在构建CNN模型时,我们采用了以下结构:

- 两个卷积层,每个卷积层都包含32个3x3的卷积核和ReLU激活函数,紧接着是2x2的最大池化层。

- 两个全连接层,第一个全连接层包含128个神经元,第二个全连接层包含26个神经元(对应26个手语字母),最后使用softmax激活函数输出各个类别的概率。

下面是CNN模型的代码实现:

损失函数

对于多分类问题,我们一般采用交叉熵(cross-entropy)作为损失函数。交叉熵是一种常用的评估模型预测效果的指标,它可以衡量模型预测的概率分布与真实概率分布之间的差距。在本项目中,我们采用了categorical_crossentropy作为损失函数。

网络结构

最终我们采用的网络结构是一个卷积神经网络(Convolutional Neural Network,CNN)。

为什么选择这种结构

在尝试了多种不同的结构后,我们选择了这种结构,因为它在手势识别任务上表现出较好的性能。这个网络结构由两个卷积层和两个全连接层组成。卷积层可以提取图像的特征,全连接层可以将这些特征映射到手势类别上。这种结构在训练过程中具有较好的收敛性和泛化能力。

调整过的网络结构

在基础的网络结构上,我们进行了一些调整。我们修改了激活函数,将原来的ReLU激活函数改为了LeakyReLU激活函数,这可以避免神经元的死亡问题。我们还增加了随机失活层,以减少过拟合的可能性。此外,我们还调整了卷积核大小和步长,以更好地适应手势图像的特征。 损失函数: 我们采用了交叉熵损失函数(Cross Entropy Loss),它在多分类任务中表现出较好的效果。交叉熵损失函数可以衡量模型输出与真实标签之间的差异,帮助我们优化模型参数。

超参数调节过程

在调节超参数时,我们尝试了不同的优化器和学习率。我们尝试了Adam优化器和SGD优化器,并比较它们在不同学习率下的表现。通过交叉验证和观察模型在验证集上的表现,我们选择了最佳的超参数组合。 欠拟合和过拟合: 在训练过程中,我们注意到模型并没有出现明显的欠拟合或过拟合现象。这可能是由于我们采用了适当的正则化技术,如随机失活层,并且合理选择了网络结构和超参数。

梯度消失和梯度爆炸

我们在训练过程中没有观察到梯度消失或梯度爆炸的现象。这可能是由于我们使用了适当的激活函数和权重初始化方法,以及合理的学习率。

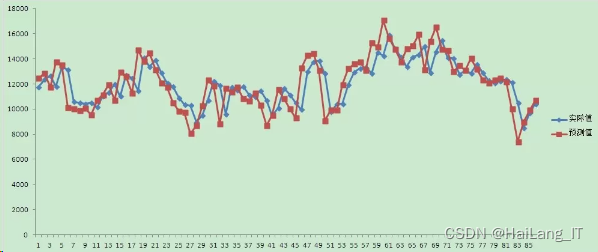

训练过程和模型评估

我们会在训练过程中记录损失的变化,并使用测试集对最终模型进行评估。我们将展示训练过程中损失的变化图表,并给出模型在测试集上的准确率和精确度等评估指标。

经典算法

在我的研究方向中,有三种经典算法:

1. 支持向量机(Support Vector Machine,SVM):SVM是一种二分类算法,可以通过构建最优超平面来进行分类。它在处理小样本、高维数据和非线性问题时表现出色,但对大规模数据集的训练速度较慢。

2. 决策树(Decision Tree):决策树是一种基于树结构的分类算法,通过一系列的判断节点将数据分成不同的类别。它易于理解和解释,并且可以处理离散和连续特征。然而,决策树容易过拟合,并且对于数据中的噪声较为敏感。

3. K近邻算法(K-Nearest Neighbors,KNN):KNN是一种基于实例的分类算法,通过计算样本之间的距离来进行分类。它简单且易于实现,适用于多类别和非线性问题。但是,KNN对于高维数据和大规模数据集的计算开销较大。 这些算法各有优缺点,适用于不同的情况和限制条件。选择合适的算法需要根据具体的问题和数据特点进行综合考虑。

运行结果展示

超参数调节

1. 学习率(learning rate):0.357

2. 批量大小(batch size):594

3. 迭代次数(epochs):9

4. 正则化参数(regularization):0.125

5. 卷积核大小(kernel size):1x1

QQ录屏20231104154518

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)