【论文阅读】基于深度学习的时序预测——Non-stationary Transformers

本文还是清华大学THUML实验室的论文,背景是在历史的研究中,大多数时序预测方法都是针对平稳型数据,但是在实际生产过程中,大部分数据其实没有那么强的平稳性,因此本文想针对这种非平稳型的数据进行模型优化;

·

系列文章链接

论文一:2020 Informer:长时序数据预测

论文二:2021 Autoformer:长序列数据预测

论文三:2022 FEDformer:长序列数据预测

论文四:2022 Non-Stationary Transformers:非平稳性时序预测

论文五:2022 Pyraformer:基于金字塔图结构的时序预测

论文六:2023 Crossformer:多变量时序预测

论文七:2023 LTSF-Linear:质疑transformer能力的线性预测模型

论文链接:https://arxiv.org/abs/2205.14415

github链接:https://github.com/thuml/Nonstationary_Transformers

参考解读:https://zhuanlan.zhihu.com/p/587665491

本文还是清华大学THUML实验室的论文,背景是在历史的研究中,大多数时序预测方法都是针对平稳型数据,但是在实际生产过程中,大部分数据其实没有那么强的平稳性,因此本文想针对这种非平稳型的数据进行模型优化;基于此,本文的主要贡献表现在一下几点:

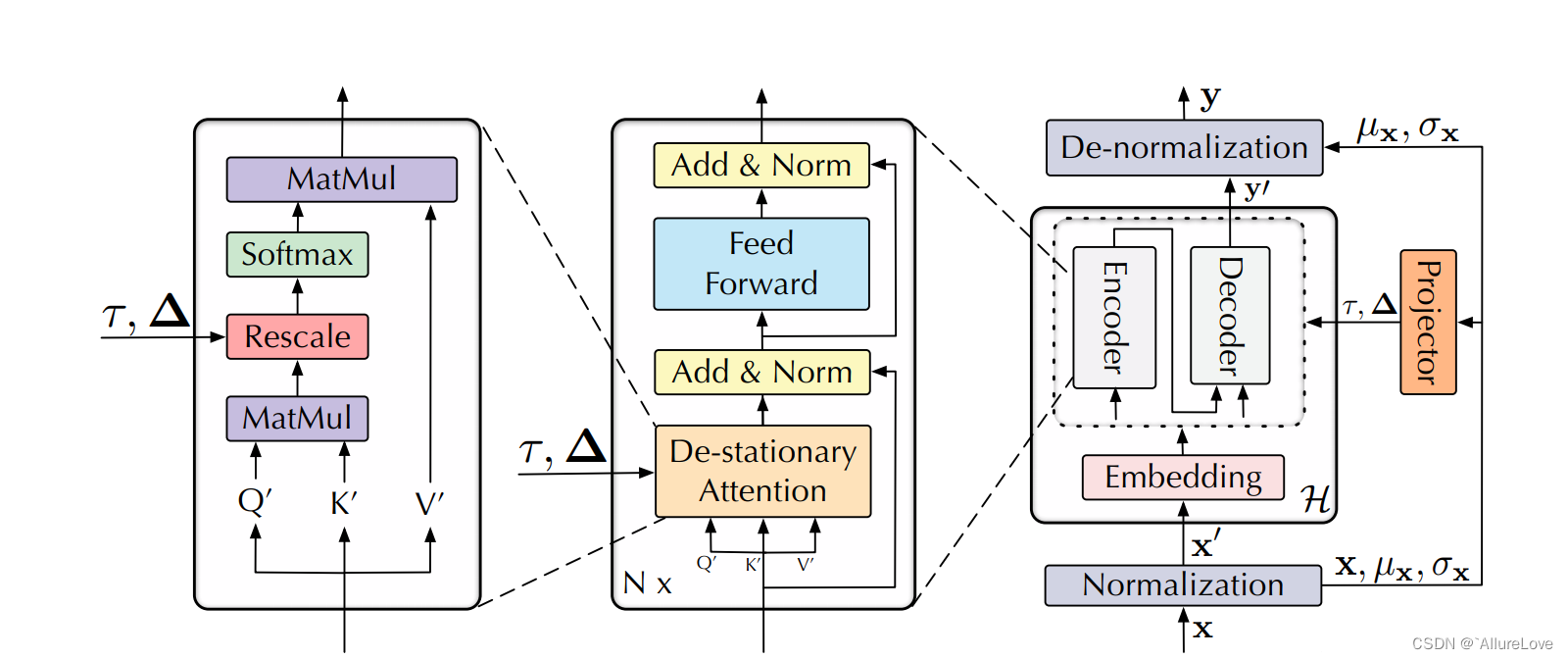

- 序列平稳化:主要体现在数据预处理方面,包含两个阶段窗口归一化(Normalization)和反归一化(De-Normalization)。对于每个指标数据,在时间维度上对数据进行归一化处理,并且在对于每个点位而言,提取的是滑动窗口内的均值数据作为样本输入(称为实例归一化),数据&实例归一化能够提高数据的平稳性。但是该操作对于原始数据而言,造成了不可逆转的退化可能性,因此本文还构造了一个逆归一化的过程,恢复数据归一化丢失的信息,该结构可以封装在模型输入输出阶段,作为非平稳型数据的特殊处理;

- 去平稳化注意力机制:虽然反归一化的处理能够还原部分信息,但是由于在模型内部输入的是归一化后的数据,所以会导致模型学习到的还是较为平稳的注意力,因此本文设计了一种新的注意力机制;基于模型嵌入层(Embedding)和前向传播层(FFN)在时间维度的线性假设,在进行注意力机制计算时不仅会输入归一化的数据,还会将归一化时的统计量输入模型,以近似未归一化的信息构造非平稳注意力表示。在进行注意力计算时,通过引入统计量尺度变换得到非平稳的注意力表示:

这种基于统计量的计算被定义为去平稳化因子;

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)